Apa itu Robots.txt? Robots.txt adalah salah satu file penting dalam pengelolaan website, terutama terkait dengan SEO dan manajemen crawler mesin pencari.

File ini sering disebut sebagai “penjaga pintu” bagi mesin pencari, karena mengatur akses mereka ke berbagai bagian situs.

Namun, banyak pemilik website yang masih kurang memahami cara kerja dan pentingnya Robots.txt.

Artikel ini akan membantu Anda memahami apa itu Robots.txt, bagaimana fungsinya, dan strategi penggunaannya secara lengkap.

Robots.txt Adalah…

Apa Itu Robots.txt

Robots.txt adalah file teks sederhana yang ditempatkan di direktori utama sebuah website.

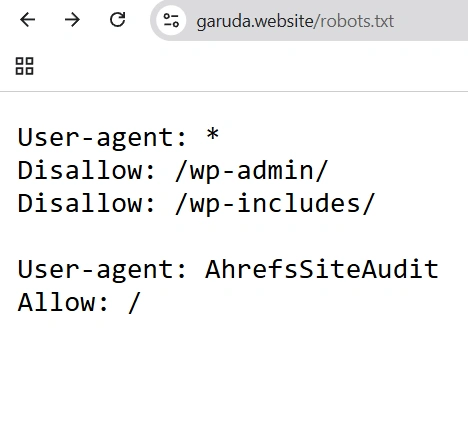

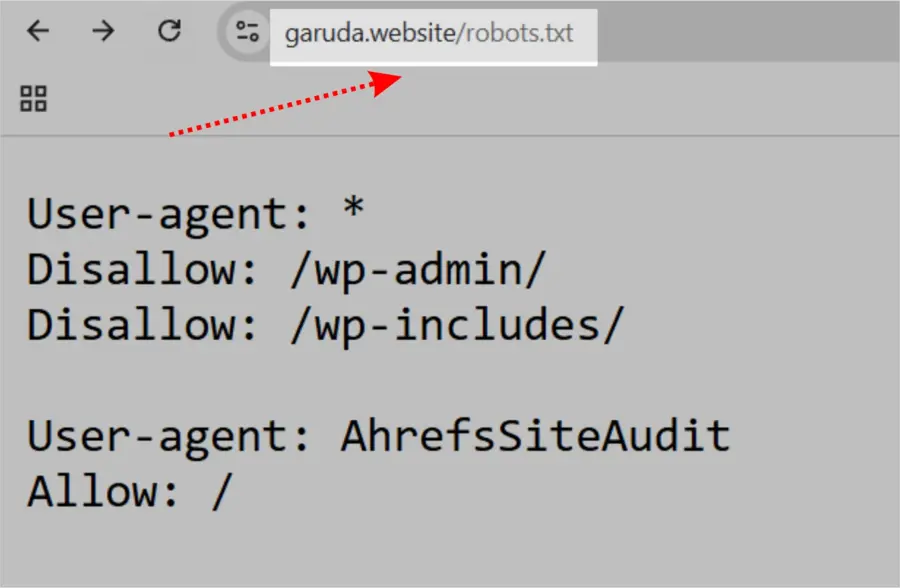

Robots.txt terlihat seperti ini:

File ini memberikan instruksi kepada crawler mesin pencari (juga dikenal sebagai user-agent) tentang halaman mana yang boleh atau tidak boleh mereka akses.

Format file robots.txt cukup sederhana meskipun terlihat teknis pada awalnya.

Sebelum membahas lebih dalam, penting untuk memahami perbedaan antara robots.txt dengan istilah lain yang mirip, yaitu meta robots dan x-robots.

Perbedaan Robots.txt, Meta Robots, & X-Robots

- Robots.txt: adalah file yang ditempatkan di direktori utama situs web dan memberikan instruksi secara luas kepada mesin pencari mengenai area situs yang boleh dan tidak boleh dirayapi.

- Meta robots: adalah tag kode yang terdapat di bagian <head> setiap halaman web dan memberikan instruksi khusus pada mesin pencari apakah halaman tersebut boleh diindeks dan tautan di dalamnya boleh dirayapi.

- X-robots: adalah tag kode yang digunakan terutama untuk file non-HTML seperti PDF dan gambar, diterapkan melalui header HTTP file tersebut.

Mengapa Robots.txt Penting untuk SEO?

File robots.txt sangat penting dalam SEO karena membantu mengelola aktivitas perayapan situs oleh mesin pencari.

Dengan pengelolaan yang tepat, robots.txt mencegah perayap membebani situs Anda dan merayapi halaman yang tidak untuk publik.

Berikut beberapa alasan utama menggunakan robots.txt:

1. Optimalkan Anggaran Perayapan (Crawl Budget)

Dengan memblokir halaman yang tidak perlu dirayapi menggunakan robots.txt, Google dapat mengalokasikan anggaran perayapan (jumlah halaman yang dirayapi dalam waktu tertentu) pada halaman-halaman penting.

Anggaran perayapan ini bervariasi tergantung pada ukuran, kesehatan, dan jumlah backlink situs Anda.

Jika jumlah halaman melebihi anggaran perayapan, halaman penting bisa saja tidak terindeks.

Halaman yang tidak terindeks tidak akan muncul di hasil pencarian, sehingga waktu dan usaha membuat halaman tersebut menjadi sia-sia.

Menurut Google, kebanyakan pemilik situs tidak perlu terlalu khawatir soal anggaran perayapan, kecuali situs dengan ribuan URL.

Baca lebih lanjut: Crawl Budget: Salah Satu Penyebab Website Tidak Terindeks

2. Blokir Halaman Duplikat dan Non-Publik

Tidak semua halaman ditujukan untuk tampil di hasil pencarian. File robots.txt memungkinkan Anda memblokir halaman-halaman non-publik dari perayap.

Contohnya adalah situs staging, halaman hasil pencarian internal, halaman duplikat, atau halaman login. Beberapa sistem manajemen konten secara otomatis mengelola halaman-halaman ini.

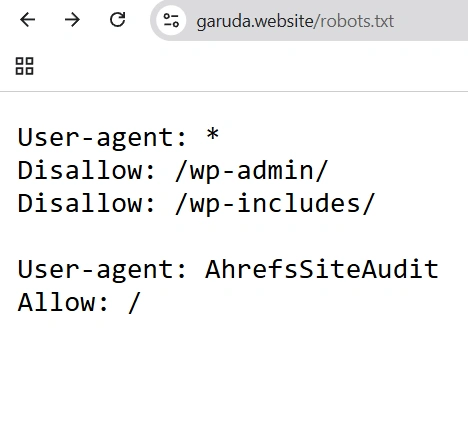

Misalnya, WordPress secara default memblokir halaman login “/wp-admin/” untuk semua perayap.

3. Sembunyikan Sumber Daya Tertentu

Dengan robots.txt, Anda juga bisa mengecualikan sumber daya seperti PDF, video, dan gambar dari perayapan jika ingin menjaga privasi atau agar Google fokus pada konten yang lebih penting.

Mengelola robots.txt dengan baik adalah bagian penting dalam strategi SEO untuk menjaga agar situs Anda terindeks secara optimal dan memberikan pengalaman terbaik bagi pengguna.

Cara Kerja Robots.txt

File robots.txt memberi tahu bot mesin pencari URL mana yang boleh dirayapi dan, yang lebih penting, URL mana yang harus dihindari untuk dirayapi.

Saat bot mesin pencari merayapi halaman web, mereka menemukan dan mengikuti tautan dari satu halaman ke halaman lainnya di berbagai situs.

Jika bot menemukan file robots.txt, bot tersebut akan membaca file ini terlebih dahulu sebelum merayapi halaman mana pun.

Sintaks dalam file robots.txt cukup sederhana. Anda menetapkan aturan dengan menentukan user-agent (bot mesin pencari) dan mengatur direktif (aturan) yang harus dipatuhi.

Anda juga dapat menggunakan tanda asterisk (*) untuk memberikan instruksi kepada semua user-agent sekaligus.

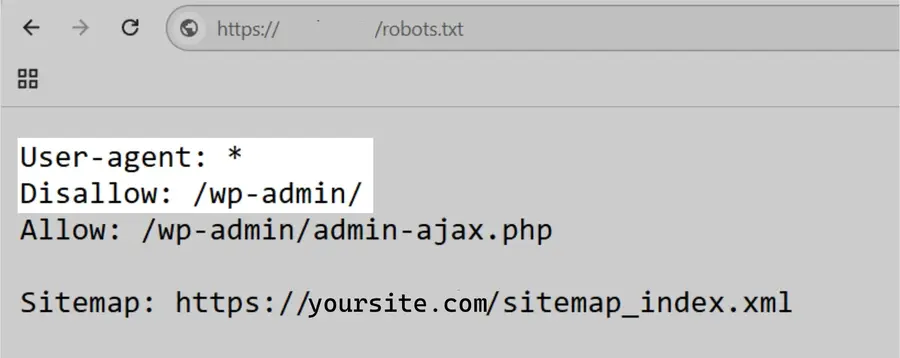

Sebagai contoh, instruksi berikut mengizinkan semua bot merayapi situs Anda kecuali membatasi akses ke beberapa direktori, sekaligus menyertakan lokasi sitemap:

File robots.txt memberikan instruksi, tetapi tidak dapat memaksa aturan tersebut dijalankan. Anggaplah file ini sebagai kode etik. Bot yang baik (seperti bot mesin pencari) akan mengikuti aturan, namun bot yang buruk (seperti bot spam) mungkin mengabaikannya.

Cara Menemukan File Robots.txt

File robots.txt Anda disimpan di server, sama seperti file-file lain di situs web Anda.

Anda dapat melihat file robots.txt dari situs mana pun dengan mengetikkan URL halaman utama situs tersebut di peramban, lalu menambahkan “/robots.txt” di bagian akhir.

Contohnya: “https://garuda.website/robots.txt”.

File robots.txt harus selalu berada di level domain root. Misalnya, untuk “www.garuda.website”, file robots.txt harus berada di “www.garuda.website/robots.txt.” Jika diletakkan di tempat lain, perayap mungkin mengira Anda tidak memiliki file tersebut.

Contoh File Robots.txt dari Situs Populer

Berikut beberapa contoh nyata file robots.txt dari situs terkenal:

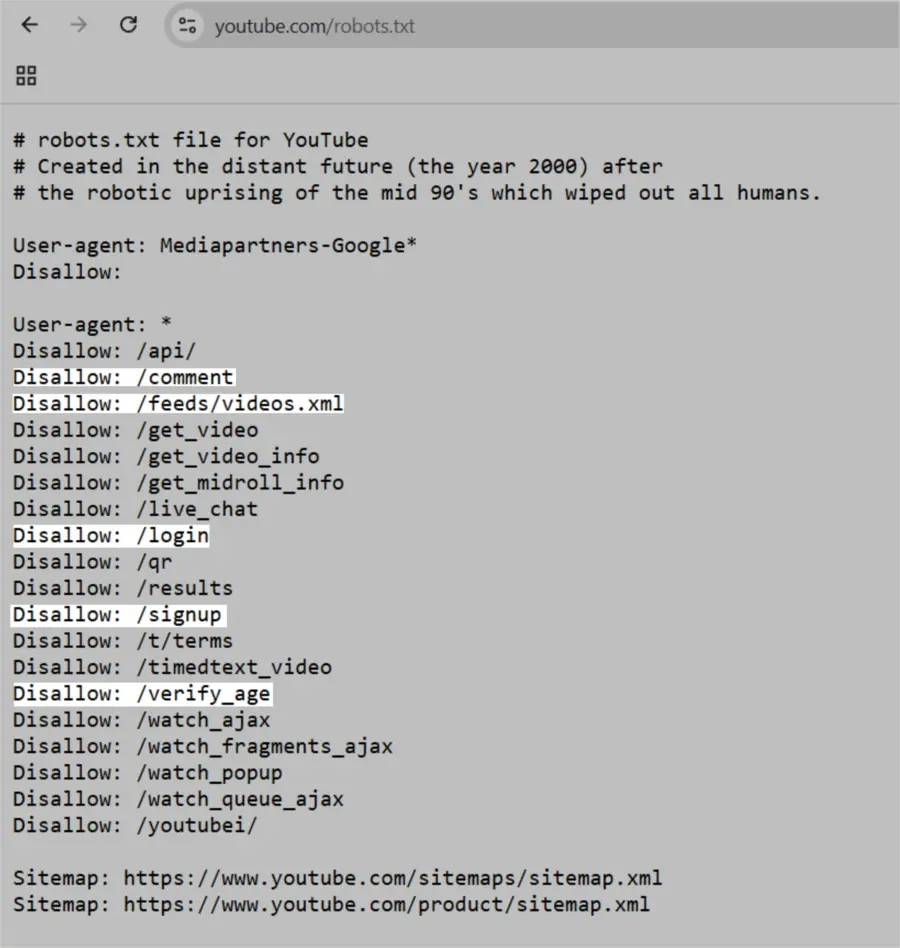

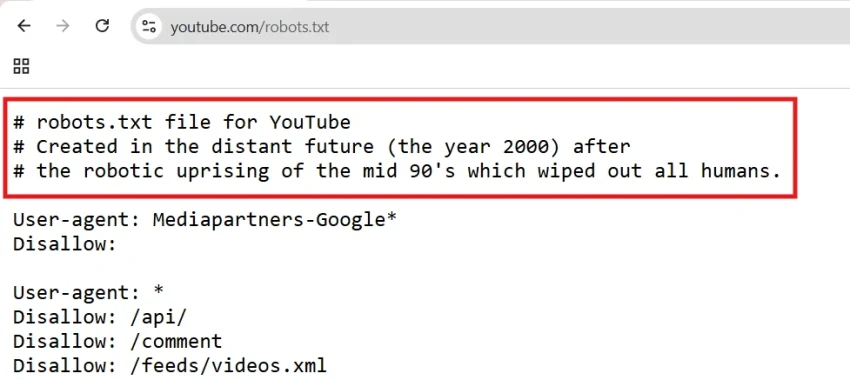

YouTube

File robots.txt YouTube memberi instruksi kepada perayap untuk tidak mengakses komentar pengguna, feed video, halaman login/daftar, dan halaman verifikasi usia.

Aturan ini mencegah pengindeksan konten dinamis atau khusus pengguna yang tidak berguna untuk hasil pencarian dan melindungi privasi pengguna.

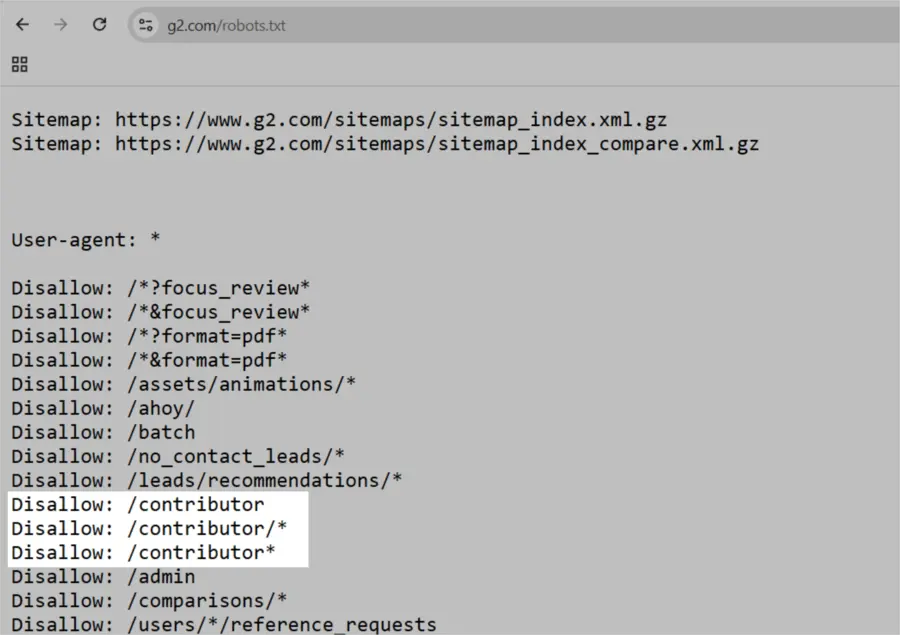

G2

File robots.txt G2 melarang perayap mengakses bagian konten yang dibuat pengguna, seperti tanggapan survei, dan profil kontributor.

Aturan ini membantu menjaga privasi pengguna dengan membatasi akses ke informasi pribadi yang sensitif dan mencegah manipulasi hasil pencarian.

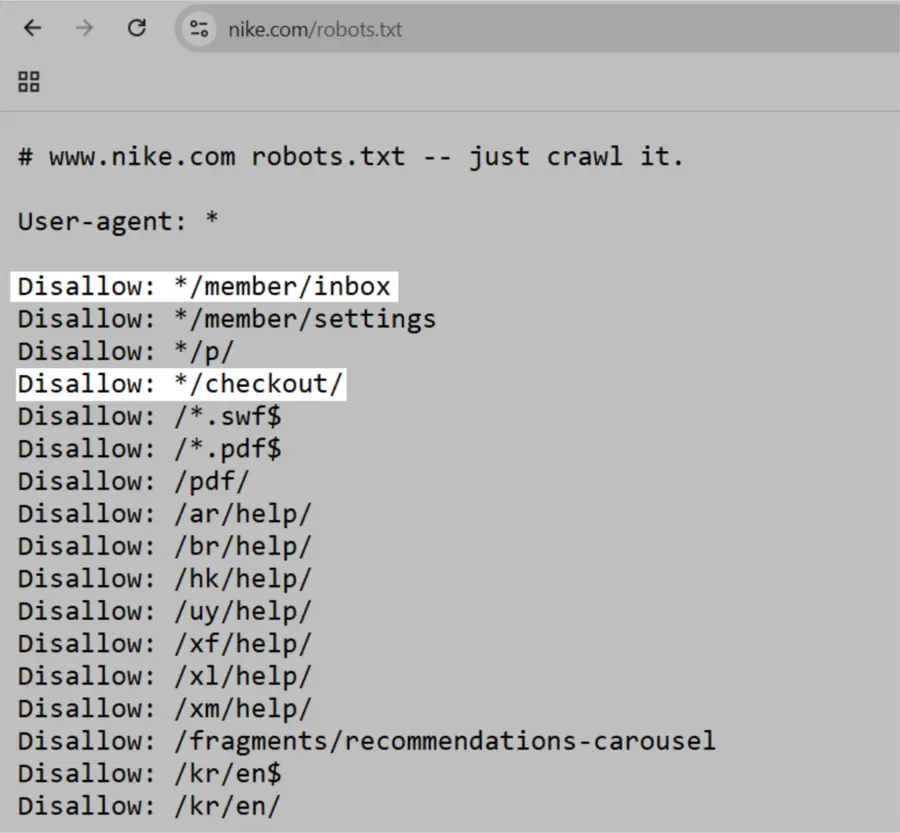

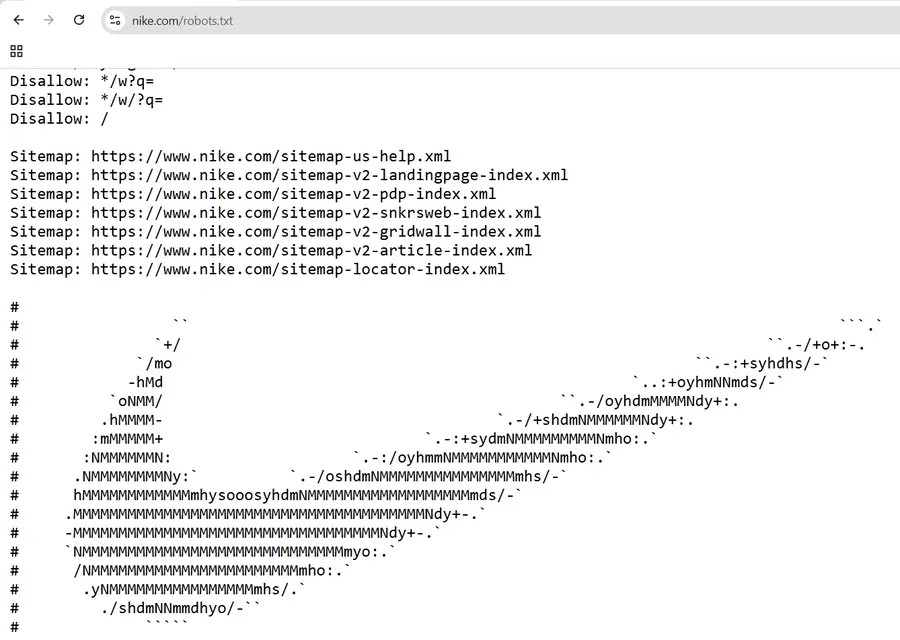

Nike

Robots.txt Nike menggunakan perintah disallow untuk memblokir perayap dari mengakses direktori dengan konten yang dibuat pengguna, seperti “/checkout/” dan “*/member/inbox.”

Hal ini mencegah data sensitif pengguna muncul di hasil pencarian dan mengurangi peluang manipulasi peringkat SEO.

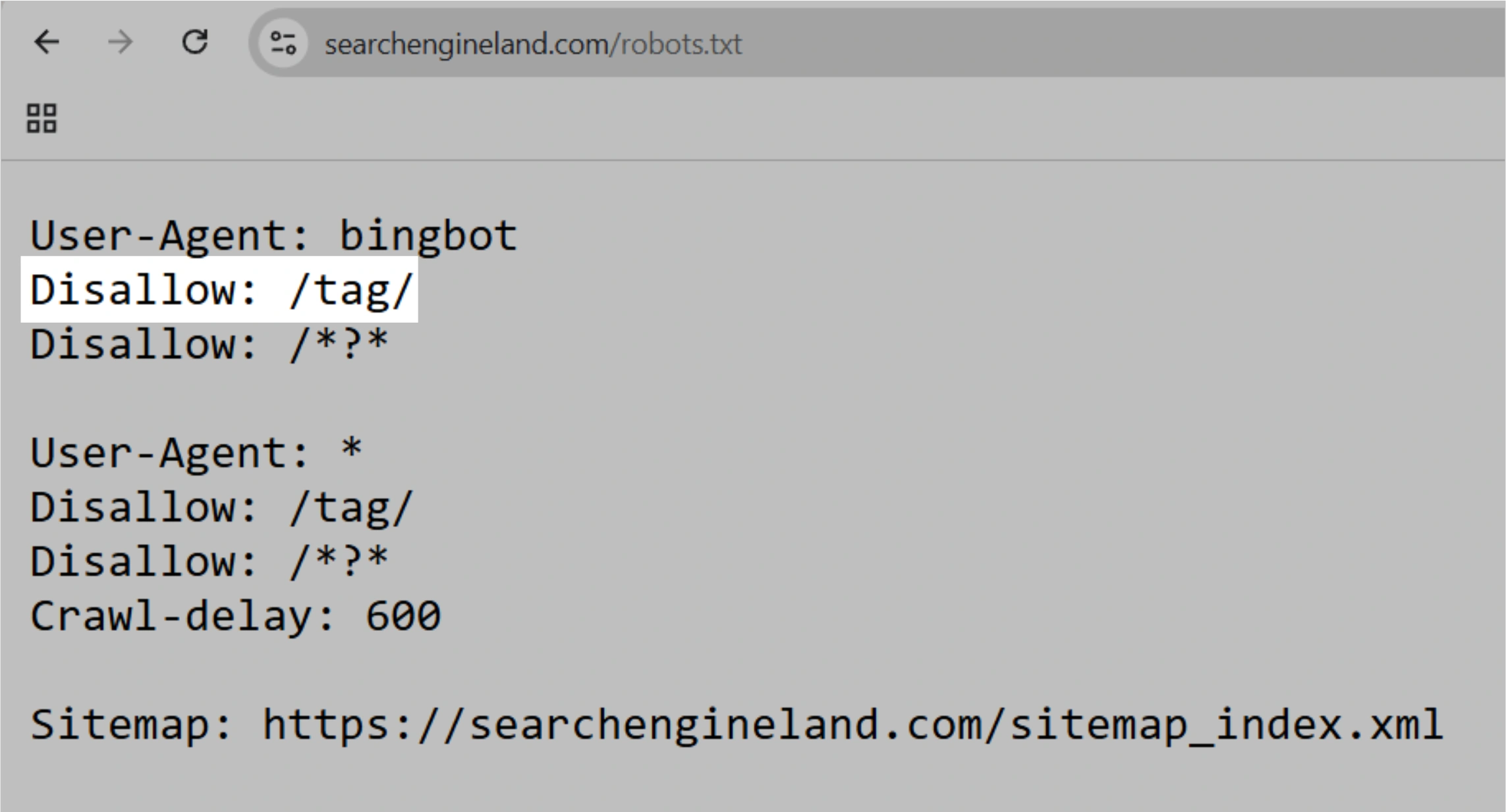

Search Engine Land

File robots.txt situs ini menggunakan tag disallow untuk mencegah pengindeksan halaman direktori “/tag/” yang biasanya memiliki nilai SEO rendah dan dapat menyebabkan masalah konten duplikat.

Aturan ini membantu mesin pencari fokus pada konten berkualitas tinggi dan mengoptimalkan anggaran perayapan hal penting bagi situs besar seperti Search Engine Land.

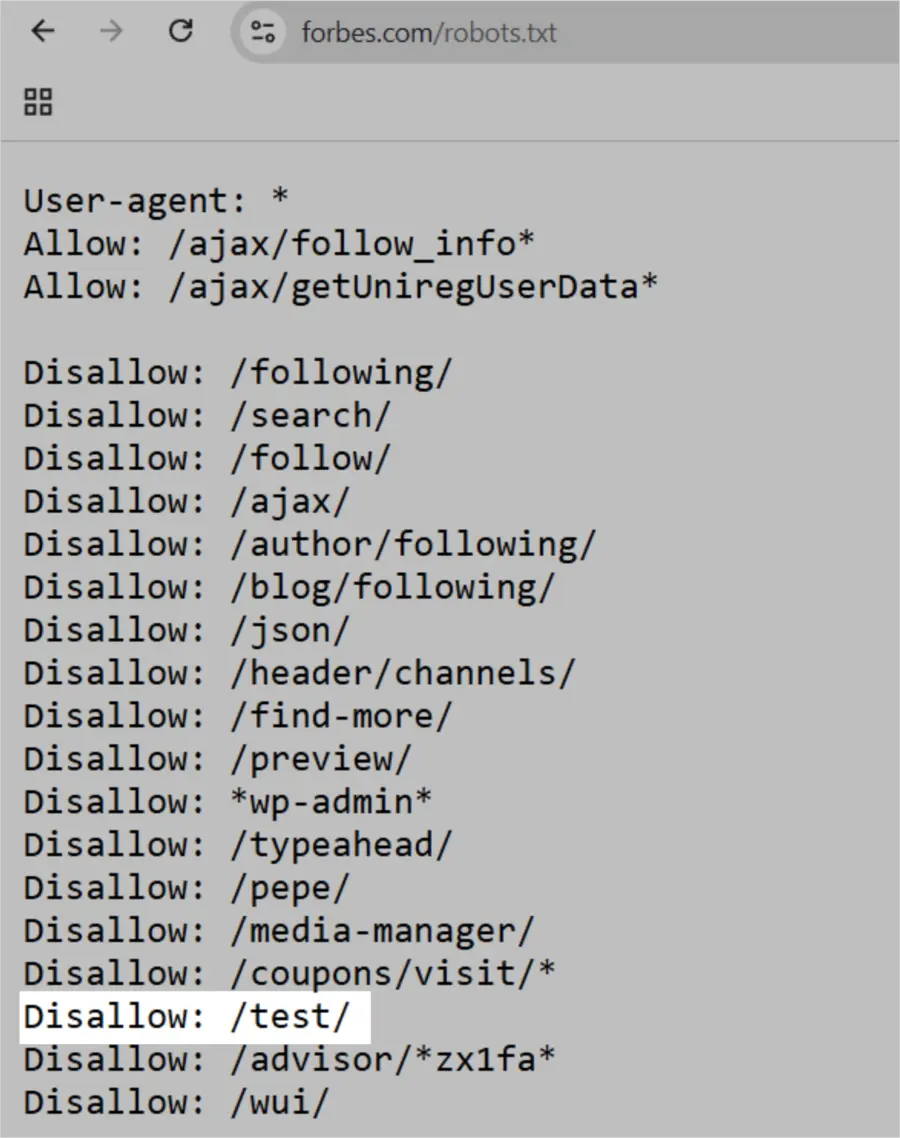

Forbes

Robots.txt Forbes menginstruksikan Google untuk tidak merayapi direktori “/test/” yang kemungkinan berisi lingkungan pengujian atau staging.

Ini mencegah konten yang belum selesai atau sensitif terindeks, dengan asumsi halaman tersebut tidak memiliki tautan dari tempat lain.

Dengan memahami cara kerja dan contoh penggunaan file robots.txt, Anda dapat lebih efektif mengelola akses mesin pencari ke situs Anda, menjaga kualitas SEO, dan melindungi konten sensitif.

Penjelasan Sintaks Robots.txt

File robots.txt terdiri dari satu atau beberapa blok direktif. Setiap blok menentukan user-agent (bot mesin pencari) dan memberikan instruksi “allow” (boleh) atau “disallow” (tidak boleh) untuk mengatur akses perayap.

Contoh blok sederhana seperti berikut:

User-agent: Googlebot

Disallow: /not-for-google

User-agent: DuckDuckBot

Disallow: /not-for-duckduckgo

Sitemap: https://www.yourwebsite.com/sitemap.xml

Direktif User-Agent

Baris pertama dalam setiap blok direktif menunjukkan user-agent, yang mengidentifikasi jenis bot perayap.

Misalnya, untuk mencegah Googlebot merayapi halaman admin WordPress Anda, gunakan:

User-agent: Googlebot

Disallow: /wp-admin/

Catatan: Sebagian besar mesin pencari menggunakan beberapa jenis bot berbeda untuk merayapi konten standar, gambar, video, dan lainnya. Jika ada beberapa direktif, bot biasanya mengikuti yang paling spesifik.

Misalnya, jika ada tiga set direktif: satu untuk *, satu untuk Googlebot, dan satu lagi untuk Googlebot-Image, maka:

- Bot Googlebot-News akan mengikuti aturan untuk Googlebot.

- Bot Googlebot-Image akan mengikuti aturan yang lebih spesifik untuk Googlebot-Image.

Direktif Disallow

Direktif ini menentukan bagian situs yang tidak boleh dirayapi oleh bot.

Jika baris disallow kosong, artinya tidak ada pembatasan.

Contoh aturan yang mengizinkan semua bot merayapi seluruh situs:

User-agent: *

Allow: /

Sedangkan untuk memblokir semua bot dari seluruh situs:

User-agent: *

Disallow: /

Catatan: Direktif seperti “Allow” dan “Disallow” tidak peka terhadap huruf kapital, namun nilai yang ada di dalamnya bersifat peka huruf. Meski demikian, biasanya kedua kata ini ditulis dengan huruf kapital untuk memudahkan pembacaan manusia.

Direktif Allow

Direktif allow memungkinkan mesin pencari merayapi subdirektori atau halaman tertentu, meskipun direktori induknya diblokir.

Misalnya, untuk melarang Googlebot merayapi semua halaman blog kecuali satu:

User-agent: Googlebot

Disallow: /blog

Allow: /blog/example-post

Catatan: Tidak semua mesin pencari mendukung direktif ini, tetapi Google dan Bing mendukungnya.

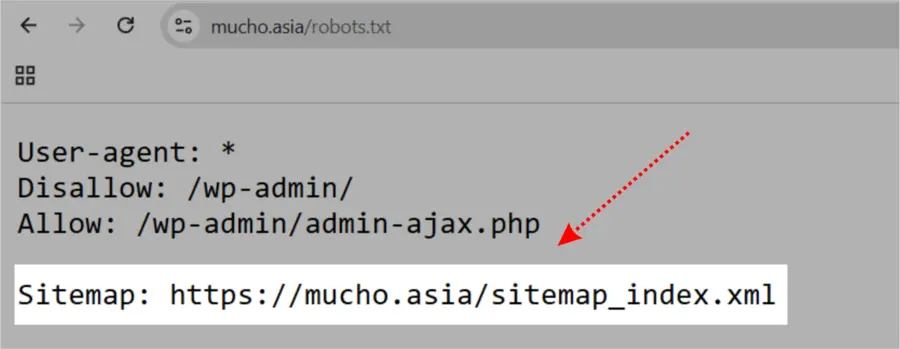

Direktif Sitemap

Direktif ini memberi tahu mesin pencari, khususnya Bing, Yandex, dan Google, lokasi file sitemap XML Anda yang berisi daftar halaman yang ingin Anda indeks.

Contoh penulisannya seperti ini:

Sitemap: https://www.yourwebsite.com/sitemap.xml

Menambahkan sitemap dalam robots.txt adalah cara cepat untuk memberitahu mesin pencari tentang sitemap Anda.

Namun, Anda juga sebaiknya mengirimkan sitemap langsung melalui alat webmaster masing-masing mesin pencari agar proses perayapan berjalan lebih cepat.

Direktif Crawl-Delay

Direktif crawl-delay mengatur jeda waktu dalam detik yang harus ditunggu bot antara satu permintaan dan permintaan berikutnya, untuk menghindari beban berlebih pada server.

Google tidak lagi mendukung crawl-delay. Untuk mengatur kecepatan perayapan Googlebot, gunakan Google Search Console.

Namun, Bing dan Yandex masih mendukung crawl-delay.

Contohnya, untuk mengatur jeda 10 detik:

User-agent: *

Crawl-delay: 10

Direktif Noindex

File robots.txt hanya menginstruksikan mesin pencari halaman mana yang boleh dirayapi dan mana yang tidak, namun tidak dapat secara andal mencegah halaman muncul di hasil pencarian, bahkan jika Anda menggunakan direktif noindex di dalamnya.

Jika menggunakan noindex dalam robots.txt, halaman tersebut tetap bisa muncul di hasil pencarian tanpa konten yang terlihat.

Google sendiri tidak pernah secara resmi mendukung direktif noindex dalam robots.txt dan menegaskan hal ini pada September 2019.

Untuk secara efektif mengecualikan halaman dari hasil pencarian, gunakan tag meta robots noindex di dalam kode HTML halaman tersebut.

Cara Membuat File Robots.txt

Anda dapat menggunakan alat pembuat robots.txt untuk membuat file ini dengan cepat.

Berikut langkah-langkah membuat file robots.txt dari awal secara manual:

1. Buat File dan Beri Nama robots.txt

Buka dokumen teks (.txt) menggunakan editor teks atau browser.

Catatan: Hindari menggunakan program pengolah kata karena biasanya menyimpan file dengan format khusus yang dapat menambahkan karakter acak.

Beri nama file tersebut “robots.txt” dan mulai ketikkan direktif yang diperlukan.

2. Tambahkan Direktif ke File Robots.txt

File robots.txt terdiri dari satu atau beberapa grup direktif, di mana setiap grup memuat beberapa baris instruksi.

Setiap grup diawali dengan user-agent yang menunjukkan bot mesin pencari yang menjadi sasaran, dan mengatur:

- Siapa user-agent yang menjadi target grup tersebut

- Direktori atau halaman mana yang boleh diakses oleh bot

- Direktori atau halaman mana yang tidak boleh diakses oleh bot

- Sitemap (opsional) untuk memberitahu mesin pencari halaman dan file penting di situs Anda

Perayap akan mengabaikan baris yang tidak sesuai dengan format di atas.

Misalnya, Anda ingin melarang Googlebot merayapi direktori “/clients/” karena halaman tersebut hanya untuk penggunaan internal.

Grup pertama dalam file Anda akan terlihat seperti ini:

makefileCopyUser-agent: Googlebot

Disallow: /clients/

Anda bisa menambahkan instruksi lain untuk Googlebot, misalnya:

User-agent: Googlebot

Disallow: /clients/

Disallow: /not-for-google

Tekan enter dua kali untuk memulai grup direktif baru.

Sekarang, misalkan Anda ingin memblokir akses ke direktori “/archive/” dan “/support/” untuk semua mesin pencari, maka tambahkan blok berikut:

User-agent: Googlebot

Disallow: /clients/

Disallow: /not-for-google

User-agent: *

Disallow: /archive/

Disallow: /support/

Setelah selesai, tambahkan juga lokasi sitemap Anda:

Sitemap: https://www.yourwebsite.com/sitemap.xml

Simpan file dengan nama robots.txt.

Catatan: Mesin pencari membaca file dari atas ke bawah dan akan mengikuti aturan yang paling spesifik terlebih dahulu. Oleh karena itu, mulailah file robots.txt Anda dengan user-agent yang spesifik, lalu lanjutkan dengan aturan wildcard (*) yang berlaku untuk semua perayap.

3. Unggah File Robots.txt

Setelah Anda menyimpan file robots.txt, langkah selanjutnya adalah mengunggah file tersebut ke situs Anda agar mesin pencari dapat menemukannya.

Proses pengunggahan file robots.txt bergantung pada layanan hosting yang Anda gunakan.

Anda bisa mencari panduan secara online atau menghubungi penyedia hosting untuk mendapatkan instruksi yang tepat.

Misalnya, cari dengan kata kunci “cara upload file robots.txt ke [nama penyedia hosting]” untuk petunjuk yang sesuai dengan platform Anda.

Berikut beberapa tautan panduan untuk mengunggah robots.txt di platform populer:

Setelah diunggah, pastikan file tersebut dapat diakses dan Google dapat membacanya dengan benar.

4. Uji File robots.txt Anda

Langkah pertama adalah memastikan bahwa file robots.txt Anda dapat diakses oleh siapa saja.

Buka jendela peramban dalam mode pribadi (private/incognito) dan masukkan URL file robots.txt Anda.

Contohnya:https://garuda.website/robots.txt

Jika isi file robots.txt muncul, lanjutkan dengan menguji struktur file tersebut.

Google menyediakan dua opsi untuk menguji robots.txt:

- Laporan robots.txt di Google Search Console

- Perpustakaan robots.txt open-source dari Google (untuk pengguna tingkat lanjut)

Jika Anda bukan pengguna tingkat lanjut, sebaiknya gunakan laporan robots.txt di Search Console.

Catatan: Anda harus memiliki akun Search Console yang sudah terhubung dengan situs Anda untuk melakukan pengujian.

Buka laporan robots.txt di Search Console.

Jika situs Anda belum ditautkan ke Search Console, tambahkan properti dan lakukan verifikasi kepemilikan situs terlebih dahulu.

Tips: Pelajari panduan lengkap tentang Google Search Console untuk memahami cara memverifikasi properti situs Anda.

Jika sudah memiliki properti yang terverifikasi, pilih salah satu dari menu dropdown setelah membuka laporan robots.txt.

Alat ini akan menampilkan peringatan dan kesalahan sintaks pada file Anda.

Anda dapat memperbaiki kesalahan atau peringatan langsung di halaman laporan dan menguji ulang secara berkala.

Perlu diingat, perubahan yang dilakukan melalui laporan robots.txt tidak otomatis tersimpan di file robots.txt asli situs Anda.

Oleh karena itu, salin dan tempel kode yang sudah diperbaiki ke file robots.txt yang sebenarnya di server Anda.

Strategi Terbaik Robots.txt

Gunakan Baris Baru untuk Setiap Direktif

Letakkan setiap direktif pada baris terpisah agar mesin pencari dapat membaca dan mengikuti instruksi dengan benar.

Contoh yang salah:

User-agent: * Disallow: /admin/

Disallow: /directory/

Contoh yang benar:

User-agent: *

Disallow: /admin/

Disallow: /directory/

Gunakan Setiap User-Agent Hanya Sekali

Cantumkan setiap user-agent sekali saja agar file tetap rapi dan mengurangi risiko kesalahan.

Contoh yang membingungkan:

User-agent: Googlebot

Disallow: /example-page

User-agent: Googlebot

Disallow: /example-page-2

Contoh yang jelas:

User-agent: Googlebot

Disallow: /example-page

Disallow: /example-page-2

Menulis semua direktif di bawah satu user-agent membuat file lebih terorganisir.

Gunakan Wildcard untuk Mengatur Instruksi Secara Luas

Wildcard (*) memudahkan pemberian instruksi yang berlaku umum.

Misalnya, untuk mencegah mesin pencari mengakses URL dengan parameter tertentu, Anda bisa saja menulis satu per satu.

Namun, menggunakan wildcard lebih efisien.

Contoh tidak efisien:

User-agent: *

Disallow: /shoes/vans?

Disallow: /shoes/nike?

Disallow: /shoes/adidas?

Contoh efisien:

User-agent: *

Disallow: /shoes/*?

Contoh di atas memblokir semua bot mesin pencari untuk merayapi semua URL dalam subfolder “/shoes/” yang memiliki tanda tanya (?).

Gunakan Tanda ‘$’ untuk Menandai Akhir URL

Tanda “$” digunakan untuk menunjukkan akhir URL.

Ini berguna saat Anda ingin memblokir semua file dengan jenis tertentu tanpa harus mencantumkan satu per satu.

Contoh tidak efisien:

User-agent: *

Disallow: /photo-a.jpg

Disallow: /photo-b.jpg

Disallow: /photo-c.jpg

Contoh efisien:

User-agent: *

Disallow: /*.jpg$

Catatan: Dalam contoh di atas, “/photo-a.jpg” tidak boleh dirayapi, tapi “/photo-a.jpg?p=32414” bisa saja dirayapi karena URL tersebut tidak berakhir dengan “.jpg”.

Gunakan tanda “$” dengan hati-hati karena kesalahan dapat menyebabkan file yang seharusnya diblokir malah dapat diakses.

Gunakan Simbol Hash (#) untuk Menambahkan Komentar

Anda dapat menambahkan komentar dalam file robots.txt dengan memulai baris menggunakan simbol “#”.

Mesin perayap akan mengabaikan semua yang diawali dengan hash.

Contohnya:

User-agent: *

#Halaman Landing

Disallow: /landing/

Disallow: /lp/

#File

Disallow: /files/

Disallow: /private-files/

#Situs Web

Allow: /website/*

Disallow: /website/search/*

Para pengembang sering menambahkan komentar lucu atau kreatif karena sebagian besar pengguna jarang melihat isi file ini.

Misalnya, file robots.txt YouTube bertuliskan: “Created in the distant future (the year 2000) after the robotic uprising of the mid 90’s which wiped out all humans.”

Sedangkan robots.txt Nike menulis “just crawl it” sebagai permainan kata dari slogan mereka “just do it,” lengkap dengan logo mereknya.

Gunakan File Robots.txt Terpisah untuk Subdomain Berbeda

File robots.txt hanya mengatur perayapan di subdomain tempat file itu berada.

Oleh karena itu, Anda mungkin perlu membuat beberapa file.

Misalnya, jika situs utama Anda adalah “domain.com” dan blog Anda berada di “blog.domain.com,” Anda perlu membuat file robots.txt untuk direktori root domain utama dan direktori root blog.

5 Kesalahan Robots.txt yang Harus Dihindari

1. File Robots.txt Tidak Ditempatkan di Direktori Root

File robots.txt harus berada di direktori root situs agar mesin pencari mudah menemukannya.

Contoh, jika beranda situs Anda adalah “www.contoh.com,” maka file harus berada di “www.contoh.com/robots.txt.”

Jika file diletakkan di subdirektori seperti “www.example.com/kontak/robots.txt,” mesin pencari mungkin tidak menemukannya dan menganggap Anda tidak memberikan instruksi crawling.

2. Menggunakan Instruksi Noindex di Robots.txt

Hindari menggunakan instruksi noindex di robots.txt karena Google tidak mendukung aturan noindex dalam file ini.

Sebagai gantinya, gunakan tag meta robots (misalnya, <meta name="robots" content="noindex">) di halaman individual untuk mengontrol pengindeksan.

3. Memblokir Akses ke JavaScript dan CSS

Jangan blokir akses ke file JavaScript dan CSS kecuali benar-benar diperlukan (misalnya untuk data sensitif).

Memblokir file ini membuat mesin pencari sulit memahami struktur dan konten situs Anda, yang dapat menurunkan peringkat.

4. Tidak Memblokir Akses ke Situs atau Halaman yang Belum Selesai

Blokir mesin pencari agar tidak merayapi versi situs yang masih dalam pengembangan untuk mencegah halaman tersebut muncul sebelum siap.

Gunakan juga tag meta robots noindex untuk setiap halaman yang belum selesai.

Jika halaman dalam pengembangan diindeks, ini dapat menurunkan pengalaman pengguna dan menimbulkan masalah konten duplikat.

Catatan:

Pastikan tidak ada tautan ke halaman dalam pengembangan yang dapat ditemukan secara online, agar baik pengguna maupun mesin pencari tidak mengaksesnya.

5. Menggunakan URL Absolut

Gunakan URL relatif dalam file robots.txt agar pengelolaan dan pemeliharaan lebih mudah.

URL absolut tidak diperlukan dan dapat menyebabkan kesalahan jika domain Anda berubah.

Contoh yang tidak disarankan:

User-agent: *

Disallow: https://www.example.com/private-directory/

Disallow: https://www.example.com/temp/

Allow: https://www.example.com/important-directory/Contoh yang disarankan:

User-agent: *

Disallow: /private-directory/

Disallow: /temp/

Allow: /important-directory/FAQs

Apa yang terjadi jika tidak ada Robots.txt?

Bot akan meng-crawl seluruh situs tanpa batasan.

Bagaimana cara memeriksa Robots.txt?

Akses langsung melalui

yourwebsite.com/robots.txt.Apakah semua bot mematuhi Robots.txt?

Tidak. Bot jahat mungkin mengabaikannya.

Kesimpulan

Robots.txt adalah alat penting untuk mengelola akses crawler mesin pencari ke website Anda.

Dengan memahami fungsi dan elemen-elemennya, Anda dapat mengoptimalkan SEO dan melindungi data penting situs Anda.

Pastikan untuk menyusun file Robots.txt dengan hati-hati dan periksa secara rutin agar tetap relevan dengan kebutuhan website Anda.